Perdono.

Perdono.

La gravità, i quanti ed i bordi.

Provocazione: noi non siamo altro che ologrammi di uno spazio-tempo granulare.

Premessa doverosa: queste considerazioni sono derivate essenzialmente da quattro assunzioni.

Qua sotto descrivo succintamente le basi del mio (s!)ragionamento.

0. Gli ologrammi.

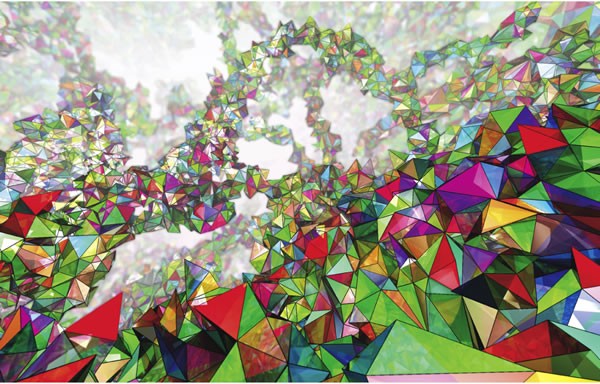

Ricordate la principessa Leila che comunica con Obi e Luke in guerre stellari? Era un ologramma.

Ricordate la principessa Leila che comunica con Obi e Luke in guerre stellari? Era un ologramma.

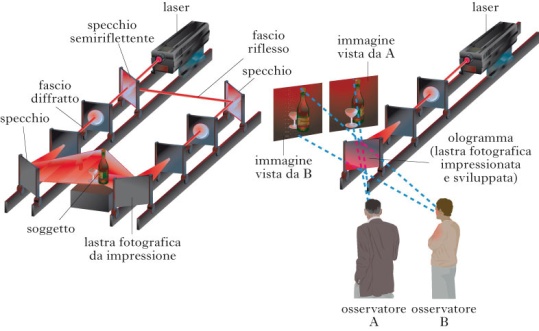

E’ un’immagine tridimensionale di un oggetto su lastra fotografica ottenuta sfruttando l'interferenza di due fasci di luce laser, uno diffratto dall'oggetto e l'altro riflesso da uno specchio.

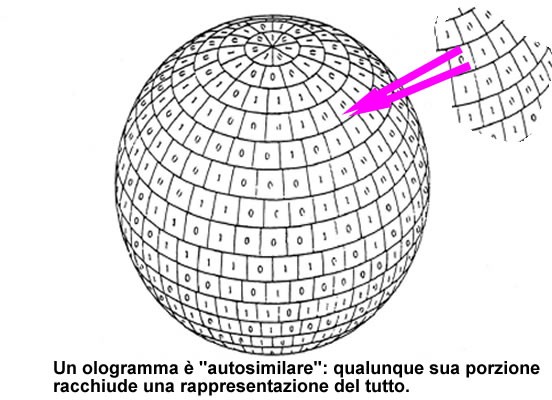

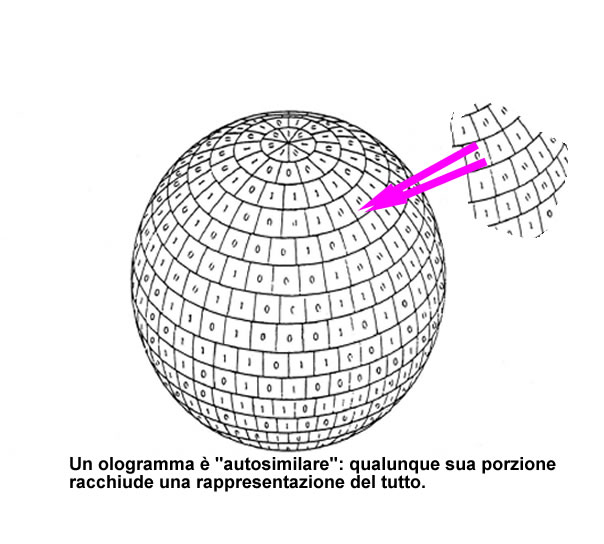

Ogni parte dell'ologramma, contiene l'intera informazione: tagliando in due parti l'ologramma entrambe mostreranno sempre l'oggetto per intero.In parole semplici posso rappresentare un oggetto tridimensionale con un oggetto(la lastra) a due dimensioni, una in meno.

La gravità quantistica a loop (LQG, dal termine inglese loop quantum gravity), conosciuta anche coi termini di gravità a loop, geometria quantistica e relatività generale canonica quantistica, è una teoria fisica di gravità quantistica, ovvero una teoria quantistica dello spazio-tempo che cerca di unificare la meccanica quantistica e la relatività generale. Rimandando ad approfondimenti specifici presenti sul web, qui possiamo dire che tale teoria cerca con successo di rendere quantizzato lo spazio tempo, mantenendo sia le caratteristiche della meccanica quantistica (indeterminazione, discretezza) che quelle della relatività generale (covarianza, indipendenza dal background). Rovelli e Smolin sono tra I pionieri di tale teoria, che personalmente reputo più completa di altre (teoria delle stringhe), che necessitano di un background indipendente per funzionare.

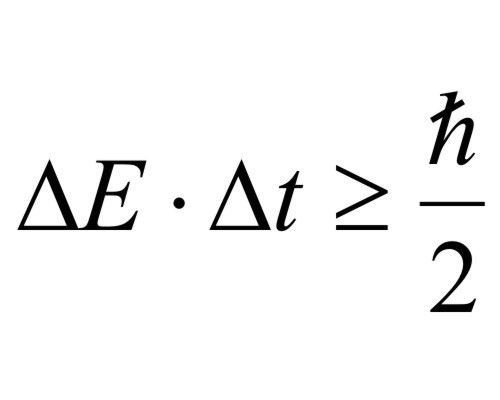

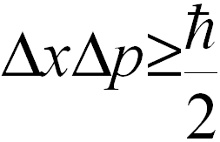

2. Principio di indeterminazione di Heisemberg

Stabilisce un limite alla precisione delle misure che possiamo fare su un sistema microscopico. Gli errori che possiamo fare circa la posizione e la quantità di moto sono inversamente proporzionali, cioè più piccolo è uno, più grande è l’altro. Inoltre, l’energia di un sistema è grosso modo dipendente dalla durata della misura.

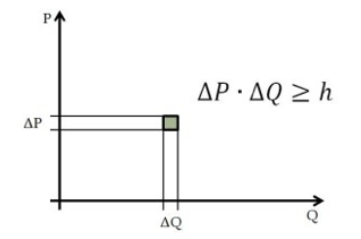

Questo principio discende dal fatto che lo spazio delle fasi di un sistema fisico microscopico non è continuo ma ha un limite minimo dato dal “quanto d’azione” di Planck. Le coordinate dello spazio delle fasi sono proprio x e p e il rettangolo minimo è proprio la larghezza di x e p .

Ps.: dovrei dire cosa è lo spazio delle fasi. Qua accenno solo al fatto che è un diagramma in cui non metto il tempo sulle ascisse e la variabile misurata sulle ordinate (ad es. La posizione), ma metto sugli assi tutte le variabili che caratterizzano completamente uno stato fisico. Un’area chiusa di questo spazio si chiama azione, ed il rettangolino che vedete in grigio è, appunto, il quanto di minima azione, h. Si capirà che in tale spazio, tassellato di rettangoli minimi, le traiettorie con sono più nè continue nè definite. Salta in aria quasi tutta la matematica classica, basata su uno spazio continuo.

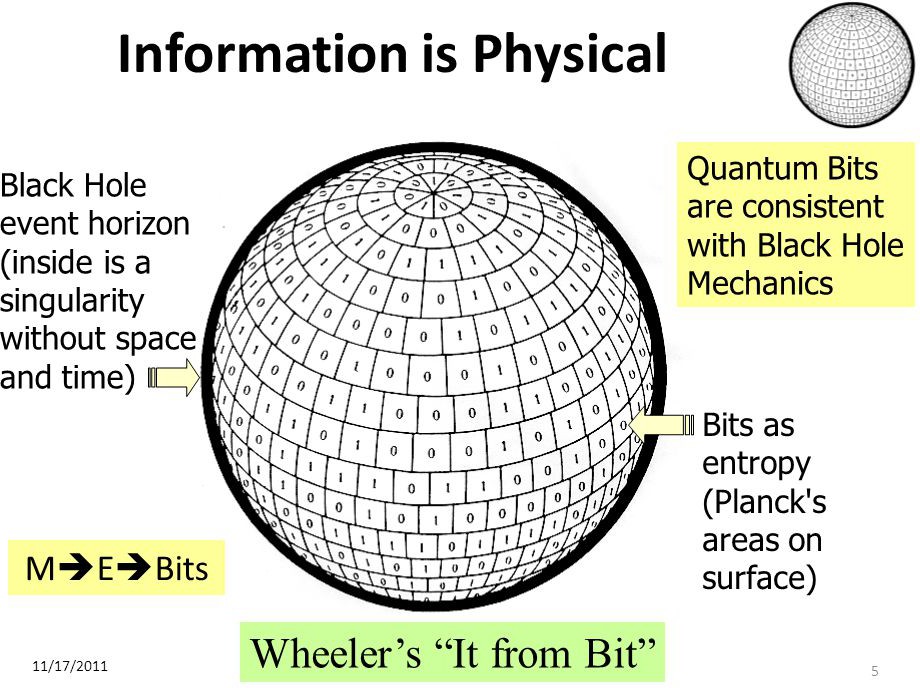

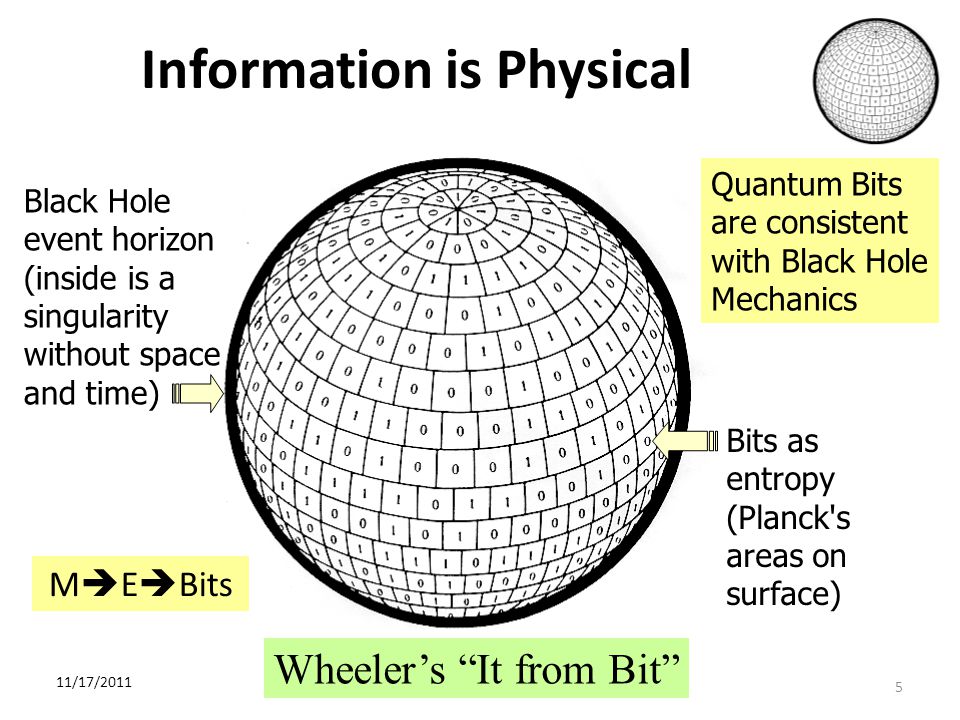

L’entropia di un buco nero è proporzionale all’area A dell’orizzonte degli eventi che lo circonda, per esser precisi è proporzionale ad un quarto di tale area. Sono presenti come costanti di proporzionalità la costante kb di Bolzmann (legame con la termodinamica) e lp, lunghezza di Planck (legame con la meccanica quantistica). Da notare che questa è anche l'entropia massima che può essere confinata in un volume di spazio che contiene una data quantità di energia ("limite di Bekenstein"). Dà grosso modo l’idea di quanta informazione sia contenuta in qualcosa che è circondata da una superficie, sulla quale è “mappata” tale informazione.

L’entropia di un buco nero è proporzionale all’area A dell’orizzonte degli eventi che lo circonda, per esser precisi è proporzionale ad un quarto di tale area. Sono presenti come costanti di proporzionalità la costante kb di Bolzmann (legame con la termodinamica) e lp, lunghezza di Planck (legame con la meccanica quantistica). Da notare che questa è anche l'entropia massima che può essere confinata in un volume di spazio che contiene una data quantità di energia ("limite di Bekenstein"). Dà grosso modo l’idea di quanta informazione sia contenuta in qualcosa che è circondata da una superficie, sulla quale è “mappata” tale informazione.

Ok, procediamo.

La natura procede a salti ed è fatta di salti. La continuità è solo un comodo espediente per semplificare la spiegazione di ciò che accade. Quando disegniamo qualcosa oppure quando vediamo la tv, se ci avviciniamo possiamo scorgere che quello che abbiamo visto o disegnato è in realtà una sequenza di punti. Tutto è quantizzato,

fatto di parti discrete e non ulteriormente divisibili. E queste parti non possono stare ferme o meglio se ne fermo alcune, altre loro caratteristiche scappano via.

Ci sono quindi dei limiti invalicabili alla conoscenza completa del mondo, non posso conoscere tutto. Inoltre la conoscenza che posso avere dipende fondamentalmente dall'interazione che ho, dalla relazione che ho, con le cose. Senza relazione non posso dire che esistano le cose, nessuno mi autorizza a farlo.

Ulteriore considerazione. Quando descrivo dei fenomeni, di qualunque natura essi siano, noto che sono inseriti in un contesto. Tutta la storia umana, non solo della scienza (pensiamo alla politica!), ha sempre inserito, anche implicitamente, ciò che accade in un sottofondo, come un palcoscenico in cui recitano degli attori. Anche le più recenti conquiste o teorie scientifiche, come la meccanica quantistica o la teoria delle stringhe, tengono conto di un sottofondo, background, dato per scontato ed "esterno" alle teorie. In altre parole, descrivo un fatto supponendo che il contesto sia dato e sostanzialmente immutabile.

La teoria generale della reltività di Einstein, invece, è il tentativo, riuscito , ma cercherò di spegare dopo, quasi riuscito, di strutturare un qualcosa di indipendente dal sottofondo, in cui cioè anche il sottofondo fa parte della rappresentazione, del luogo specifico in cui accadono i fenomeni. Parte integrante ed interagente, non passiva, inerte. E la nuova fisica deve muoversi così: indipendenza dal background (si chiama covarianza) e pure indipendente dal particolare sistema di coordinate che uso (diffeomorfismo). La nuova teoria deve gestire solo le relazioni tra gli elementi interagenti, che generano sia l'evoluzione dei fenomeni che il luogo in cui si svolgono. Le relazioni generano l'esistenza stessa delle cose.

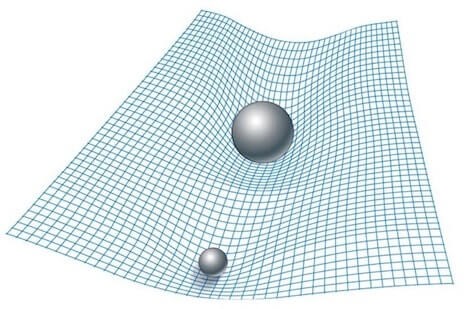

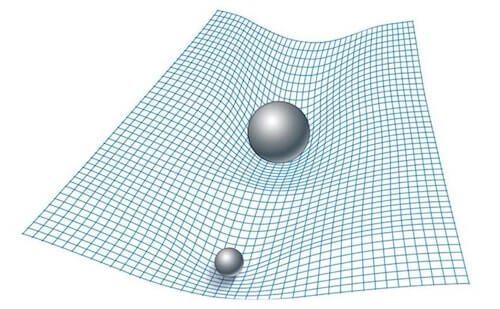

Come accennavo, la teoria della relatività generale spiega molto bene i fenomeni gravitazionali su media e larga scala. E lo fa ipotizzando che la forza di gravità è un effetto della curvatura geometrica dello spazio-tempo. Le masse curvano tale spazio- tempo e la curvatura determina le traiettorie delle masse stesse, in un continuo ed incessante balletto. Tale teoria però presuppone che lo spazio-tempo sia continuo e tale caratteristica porta alla perdita di significato della teoria stessa quando tratta di masse molto grandi concentrate in uno spazio molto piccolo (buchi neri). Le grandezze in gioco, come le masse ed i volumi, divergono: o infinite o infinitamente piccole. Affiorano inoltre dei paradossi, come la perdita totale delle informazioni che cadono dentro un buco nero, cosa reputata impossibile. Tentare di risolvere tali limiti è lo sforzo di tutto un settore della fisica che si occupa di fondere la relatività generale con l'altra teoria della natura, la meccanica quantistica, che ha un approccio con gli infiniti meno traumatico. E come si cerca di farlo?

Anche lo spazio ed il tempo sono quantizzati, granulari. Lo spazio cioè è suddivisibile fino ad un certo punto, che si chiama lunghezza di Plank, pari a qualcosa come 1,6 10-35 metri. E' un valore molto piccolo. Se un protone fosse grande come il sole, tale distanza sarebbe meno di un millimetro, ma è pur sempre diversa da 0. La meccanica quantistica impone tale limite: se ci fosse un valore minore tutto l'universo, tutte le particelle in esso contenute, collasserebbero in un buco nero.

Se un protone fosse grande come il sole, tale distanza sarebbe meno di un millimetro, ma è pur sempre diversa da 0. La meccanica quantistica impone tale limite: se ci fosse un valore minore tutto l'universo, tutte le particelle in esso contenute, collasserebbero in un buco nero.

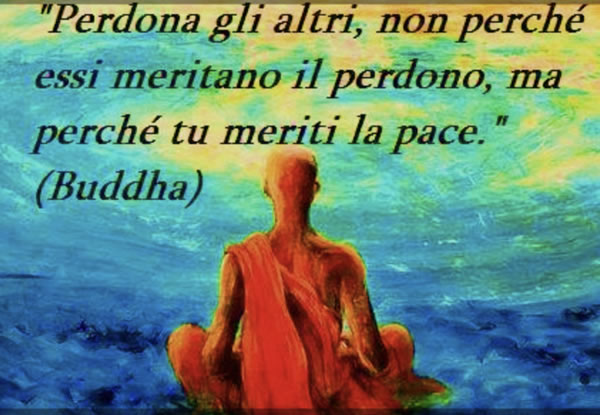

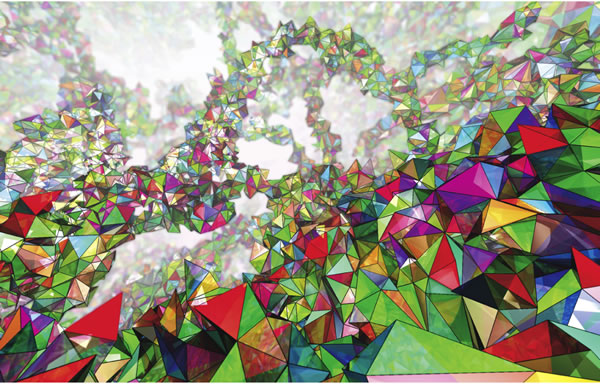

La lunghezza di Plank determina la superfice ed il volume di Plank basta farne il quadrato o il cubo). Lo spazio-tempo è cioè una sorta di reticolo, di "cubetti" piccolissimi che riempiono tutto l'universo ed in cui sono collocate e si muovono tutte le masse. Tale reticolo, a sua volta, sempre per le leggi della meccanica quantistica (principio di indeterminazione di Heisemberg), non può stare fermo ma si agita, si deforma, è più simile alla schiuma da barba che ad una rete. Al vertici di tale reticolo sono collocati gli atomi di spazio. I fisici lo chiamano "schiuma di spin". Nella figura all’inizio è rappresentata una simulazione di tale "spin foam". La parola spin sottintende che sono strutture orientate e quindi capaci potenzialmente di possedere una qualche informazione, cosa che ci potrà tornare utile in seguito.

Questa impossibilità di star fermi e quindi di stare sempre in interaziore reciproca, deformandosi, allargandosi, stirandosi dipende dal fatto che anche gli atomi di spazio obbediscono, appunto, al principio di indeterminazione di Heisemberg, uno dei pilastri della meccanica quantistica. Tale principio stabilisce, oltre alla impossibilità di avere misure precise contamporanee della posizione e della velocità (per essere più precisi, quantità di moto) delle particelle, anche l'impossibilità di misurarne la loro energia con precisione. Sono fatti acclarati, strani e non intuitivi, ma senza di esso non funzionerebbero i cellulari. Questa indeterminazione dell'energia, in questo caso degli atomi di spazio, come vedremo, ha ripercussioni fondamentali nell'evoluzione di tutto l'universo. Facciamo prima una premessa terminologica; la differenza tra vuoto e niente. Il vuoto è lo spazio senza materia. Il niente è ciò che sta tra gli atomi di spazio. Le interazioni fondamentali della natura, forte, debole ed elettromagnetica si hanno anche nel vuoto, mentre gli atomi di spazio non hanno bisogno di nulla per interagire. Lo spazio è granulare. Strano, no?

Detto questo, l'indeterminazione sull'energia dei quanti di spazio può determinare che lo spazio possa acquistare un'energia diversa da 0 ed anche esercitare una pressione. Da qui può derivare una caratteristica misurata dello spazio vuoto: la costante cosmologica, una pressione espansiva molto bassa ma capace di spingere l'universo ad espandersi in modo accellerato. La storia della costante cosmologica è una corsa ad ostacoli, via via superati. La quantizzazione dello spazio cioè può essere la spiegazione della sua pressione intrinseca, non gli effetti quantomeccanici della materia, che porterebbero a previsioni assurde sul valore della costante cosmologica Λ. Se volete approfondire cosa sia il vuoto fisico e che proprietà possiede potete dare uno sguardo a questo video cosa è i l vuoto quantistico . Attenzione, però! Anche se appare tutto strano ed esoterico, dobbiamo tener presente che le caratteristiche del vuoto attuali sono comunque un fatto standard e consolidato. Qui si cerca di fare uno step in più, piuttosto temerario. vediamo come.

A questo punto possiamo fare un'ipotesi sulla gravità. Quante volte abbiamo visto un'immagine del genere? Masse che distorcono la struttura geometrica dello spazio-tempo come palle su una rete elastica? ma cosa è questa rete? Possiamo dare una possibile risposta: è il reticolo degli atomi di spazio che viene distrurbato dalla presenza della materia. Lo spazio si deforma e quindi le traiettorie di tutti gli oggetti si deformano, compreso la luce che lo attraversa. Le traiettorie naturali degli oggetti seguono le deformazioni del reticolo e si incurvano; ecco l'affioramento della gravità.

A questo punto possiamo fare un'ipotesi sulla gravità. Quante volte abbiamo visto un'immagine del genere? Masse che distorcono la struttura geometrica dello spazio-tempo come palle su una rete elastica? ma cosa è questa rete? Possiamo dare una possibile risposta: è il reticolo degli atomi di spazio che viene distrurbato dalla presenza della materia. Lo spazio si deforma e quindi le traiettorie di tutti gli oggetti si deformano, compreso la luce che lo attraversa. Le traiettorie naturali degli oggetti seguono le deformazioni del reticolo e si incurvano; ecco l'affioramento della gravità.

Bordi.

Fino a questo punto abbiamo trattato lo spazio e la materia in esso contenuta in modo diverso: sono pur sempre entità distinte anche se la teoria quantistica della gravità è indipendente dal background. Essa va intesa sempre nel senso che "la materia incurva lo spazio-tempo e la curavatura dice alla materia come muoversi". Ma qui entrano in gioco Archibald Wheeler, Steven Hawking e Bekenstein.

I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo ( h ttps://www.giamod.it/nuova/index.php/84-fisica-e-dintorni/163-bit-dell-universo ) che dà il via al concetto di universo olografico, tramite il quale possiamo concepire il nostro modo descritto completamente dai bits (qbits) immagazzinati nel bordo che lo circonda. Ma osserviamo che non è necessario pensare ad un bordo universale tassellato di celle della dimensione di aree di Plank: ogni bordo che circonda qualunque cosa presente nel nostro universo contiene le informazioni necessarie e sufficienti per descrivere cosa c'è dentro di esso. Ed allora: se la schiuma di spin nel suo eterno cambiare forma per gli effetti quantistici che la governano di "corrugasse" in una  forma chiusa, in un bordo, appunto, cosa accadrebbe?

forma chiusa, in un bordo, appunto, cosa accadrebbe?

Si creerebbe una massa! Le masse non sono altro che bordi di una struttura granulare chiusa dello spazio tempo. La massa non è più qualcosa di esterno allo spazio, ma è lo spazio stesso non piatto ma chiuso in bolle . Tali bolle possono avere energia e/o struttura sufficiente per essere stabili ed allora generano materia sufficientemente stabile (protoni, elettroni, neutroni , quarks) oppure rompersi generando materia instabile (material oscura?). Un bordo può racchiudere uno o altri bordi, creando strutture via via più grandi.

L'informazione diviene sempre più ricca e complessa arrivando a rappresentare qualunque cosa presente nell'universo, come una immensa matrioska fatta di pura informazione, capace anche di fare questo: osservare se stessa e studiarla (cioè, noi).

In più, se osserviamo la figura a lato, ed applicando una delle proprietà degli ologrammi, il fatto cioè che qualunque sua porzione contenga le informazioni di tutto l'ologramma, possiamo in qualche modo dedurre che cose anche molto lontane nel mondo tridimensionale siano in realtà vicinissime sul bordo, separate cioè da pochissimi atomi di spazio. Sulla superficie cioè scompare la distanza macroscopica. Ecco spiegata la non località della meccanica quantistica: oggetti apparentemente lontanissimi in realtà possono esere vicinissimi. ecco spiegato l'entanglement.

Cioè, in altre parole, tutto l'universo non è altro che l'emergere di pura e semplice informazione.

Naturalmente i problemi aperti sono molteplici: 1) quali sono le forme più probabili che portano alla creazione della materia barionica( quarks, elettroni) e 2) come sono scritti i bits sui bordi?

Come è strano il mondo. Non ha niente a che vedere con ciò che appare. Omaggio a Rovelli.

Continuo quanto detto nel mio articolo sui bordi e vediamo come sia possibile ipotizzare una spiegazione sulla materia oscura, uno dei misteri tuttora irrisolti.

Tutto ebbe inizio con Fritz Zwicky, che, nei primi anni ’30 del secolo scorso, intraprese uno studio sistematico dell’ammasso della Chioma, un aggregato di migliaia di galassie, largo circa 20 milioni di anni luce, a circa 350 milioni di anni luce dalla Terra, nella direzione della costellazione detta Chioma di Berenice.

Zwicky eseguì due tipi di misure, che costituiscono il pane quotidiano degli astrofisici: stimò la massa totale dell’ammasso dal numero delle galassie che poteva vedere e dalla sua luminosità totale; dalla misura dello spostamento Doppler della luce emessa, invece, determinò le velocità radiali, ovvero lungo la linea di vista, delle galassie.

Con questi dati a disposizione, Zwicky fu in grado di calcolare le energie totali di movimento (cinetica) e gravitazionale contenute nell’ammasso. Un famoso teorema della fisica Newtoniana afferma che, in un sistema chiuso, qual è un ammasso, la prima deve essere metà della seconda. Zwicky, però, non trovò questo. Secondo le sue misure, le singole galassie si muovevano troppo velocemente perché l’ammasso potesse mantenersi compatto. Con le velocità osservate, l’ammasso avrebbe dovuto “evaporare”: le galassie non sarebbero state viste raggruppate, ma in fuga l’una dall’altra.

Per risolvere questa situazione paradossale Zwicky avanzò l’idea che l’ammasso contenesse anche della massa invisibile, ovvero materia che esercita attrazione gravitazionale ma che non emette luce, non contribuendo, quindi, alla luminosità della galassia. Zwicky coniò il temine “materia oscura” per descrivere questa componente invisibile che stimò essere almeno 500 volte di più della materia visibile. Successivamente, con la nascita dell’astronomia ai raggi X, si scoprì che molta di questa “massa mancante” era in realtà nella forma di gas caldi (potenti emettitori di raggi X), i quali danno un contributo alla massa totale delle galassie di gran lunga maggiore di quello delle stelle visibili. Però, anche tenuto conto dei gas, al bilancio totale di massa mancava ancora un contributo importante, circa 5-6 volte quello della massa visibile.

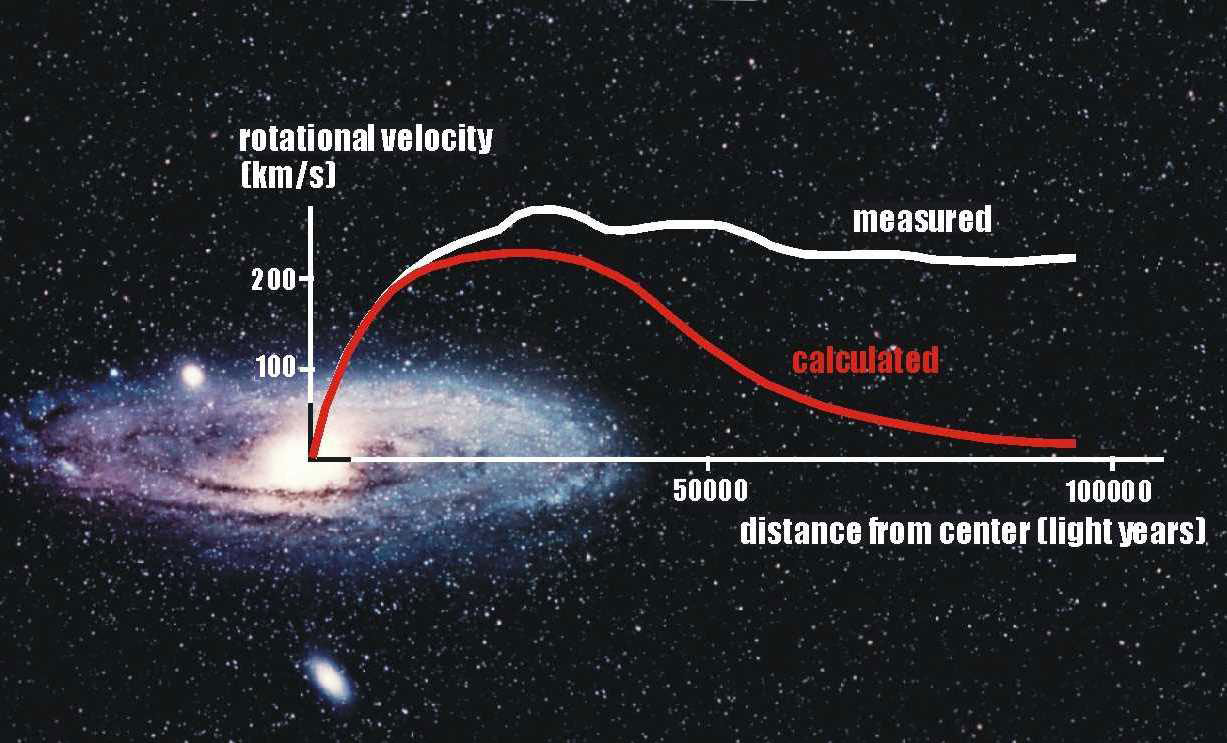

Nei quarant’anni successivi l’osservazione di Zwicky, gli astronomi non compirono alcun progresso sostanziale nello studio di questa anomalia. Poi, all’inizio degli anni ’70, Vera Rubin, insieme al suo collaboratore, Kent Ford, iniziò a studiare le cosiddette curve di rotazione delle galassie a spirale. Una curva di rotazione è l’andamento della velocità di rotazione all’interno di un sistema astronomico in funzione della distanza dal centro del sistema stesso. La prima curva di rotazione misurata è stata quella del Sistema Solare. Qui la velocità di rotazione intorno al Sole, come evidenziata dal moto dei pianeti, decresce con la radice quadrata della distanza dal Sole. La curva di rotazione del Sistema Solare è consistente con tutta la quasi totalità della massa del sistema localizzata nel centro, ovvero il Sole, e con la legge universale della gravità di Newton. Anzi, possiamo dire che questo accordo è la prima indicazione della validità di questa legge sulla scala di distanze del Sistema Solare.

Rubin si aspettava di trovare l’andamento predetto dalla legge di gravità di Newton, nella Fig. 1 rappresentato dalla curva rossa. Neanche per idea: nelle galassie, ben oltre la massa visibile, la velocità di rotazione a grande distanza dal centro della galassia è pressoché costante! (la curva bianca in figura).

Fig. 1 – Curva di rotazione di una tipica galassia a spirale. La curva rossa è la predizione della legge di gravità Newtoniana; quella bianca rappresenta l’andamento delle misure sperimentali

Fig. 1 – Curva di rotazione di una tipica galassia a spirale. La curva rossa è la predizione della legge di gravità Newtoniana; quella bianca rappresenta l’andamento delle misure sperimentaliÈ importante precisare un punto. Come si vede dalla figura, la curva si estende ben aldilà della regione delle stelle più esterne. In questa regione la velocità di rotazione è quella delle nubi di idrogeno ionizzato che ruotano intorno al centro della galassia. Queste nubi emettono radiazione con una determinata lunghezza d’onda – la cosiddetta linea Hα con λ = 21 cm -, facile da rivelare. È dallo spostamento Doppler di questa linea che Rubin fu in grado di determinare la velocità orbitale delle nubi periferiche.

Nell’ambito della meccanica Newtoniana, la curva bianca di Figura 1 può essere compresa soltanto se la distribuzione di massa si estende ben oltre quella della luce stellare visibile, il che equivale a dire che la massa nelle regioni esterne della galassia è oscura. Il fenomeno è generale: la curva di rotazione rimane piatta aldilà del disco visibile in praticamente tutte le galassie a disco osservate con sufficiente dettaglio. Nel contesto dell’ipotesi della materia oscura, questo implica che ogni galassia è immersa in una più estesa componente oscura, una sorta di alone all’interno del quale questa materia ha una distribuzione ben precisa: la sua densità deve decrescere con il quadrato della distanza dal centro galattico.

Questo non è il solo “lato oscuro” dell’Universo. Purtroppo, ce n’è un altro, ben più inquietante, che non possiamo fare a meno di citare. Nel 1998, due gruppi di astrofisici, negli Stati Uniti e in Australia, studiando una particolare classe di supernove, cosiddette di tipo Ia, esplose tra 4 e 7 miliardi di anni fa, fecero una scoperta sorprendente: le supernove lontane hanno, in media, una luminosità il 25% più piccola di quanto aspettato.

Abbastanza rapidamente ci si rese conto che l’unica spiegazione plausibile per questo fenomeno era che le supernove lontane fossero più distanti di quanto si pensasse. Questo diviene perfettamente spiegabile se ammettiamo che nel passato l’universo si espandeva più lentamente di quanto si deduce a partire dalla velocità d’espansione attuale. Detto in un altro modo, l’Universo sta attraversando una fase di espansione accelerata, in cui la sua evoluzione è dominata da una misteriosa “energia oscura”.

Ma torniamo al problema della materia oscura; avremo modo di discutere più a fondo dell’energia oscura in un’altra occasione. Attualmente, due sono le idee che, con diversa attenzione, circolano nella comunità dei fisici.

Materia oscura come particelle

La soluzione più semplice, e probabilmente quella più popolare tra i fisici, per spiegare questo evidente ammanco di massa consiste nel postulare che l’alone che circonda la galassia sia popolato di particelle elementari, elettricamente neutre, stabili e massive sin qui non ancora osservate. Il fatto che tali particelle siano neutre spiega la ragione per cui risultino invisibili, non potendo emettere radiazione elettromagnetica di nessun genere. Il fatto che siano massive è necessario per spiegarne gli effetti gravitazionali.

Ci sono molte buone ragioni a sostegno di questa ipotesi “particellare”.

Innanzitutto, sappiamo che la materia ordinaria, quella di cui abbiamo quotidiana esperienza e di cui noi stessi siamo costituiti, consiste di ben determinate particelle elementari: quelle che compongono il cosiddetto Modello Standard. Tutti i fenomeni fisici a noi noti sono descritti a livello fondamentale da combinazioni ed interazioni di e tra queste particelle, secondo leggi che hanno ricevuto, e continuano a ricevere, conferma dagli esperimenti. Sembra quindi ragionevole pensare che anche il “mondo oscuro” replichi questa caratteristica corpuscolare della materia ordinaria. Incidentalmente, notiamo che ci sono solide ragioni, che qui non discutiamo, per escludere che la materia oscura sia costituita dalle particelle del Modello Standard.

La seconda ragione è dettata dall’esperienza. Storicamente sono molti i problemi fisici che sono stati risolti introducendo nuove particelle ad hoc. L’esempio più noto è forse quello del neutrino. Negli anni ‘30 del secolo scorso lo studio di alcuni fenomeni di decadimento radioattivo mostrava una preoccupante ed inspiegabile violazione del principio di conservazione dell’energia, che impone ad ogni sistema fisico isolato di mantenere inalterata la quantità di energia totale indipendentemente dal processo fisico cui è sottoposto. Per questi processi, invece, sembrava che una consistente parte dell’energia iniziale si perdesse letteralmente nel nulla. Il fisico austriaco Wolfgang Pauli ipotizzò pertanto che questa energia fosse “portata via” da una leggerissima particella neutra, dalle caratteristiche tanto elusive da non poter essere osservata. Enrico Fermi fece sua l’idea di Pauli ed elaborò una rigorosa teoria per questo tipo di processi (i cosiddetti decadimenti beta) battezzando “neutrino” la nuova misteriosa particella. La teoria di Fermi era talmente elegante e descriveva in maniera così precisa la dinamica dei processi beta, che l’esistenza del neutrino fu accettata anche in assenza di prove dirette. Si dovettero aspettare più di due decenni prima che i fisici americani Frederick Reines e Clyde Cowan riuscissero finalmente a catturare qualche neutrino prodotto da un reattore nucleare.

Ma la prova più stringente a favore della natura particellare della materia oscura è di carattere cosmologico. Infatti, se al momento della formazione del fondo cosmico a microonde (CMB dall’acronimo inglese) nell’Universo fossero stati presenti solo fotoni e materia ordinaria, l’entità attuale delle flutt

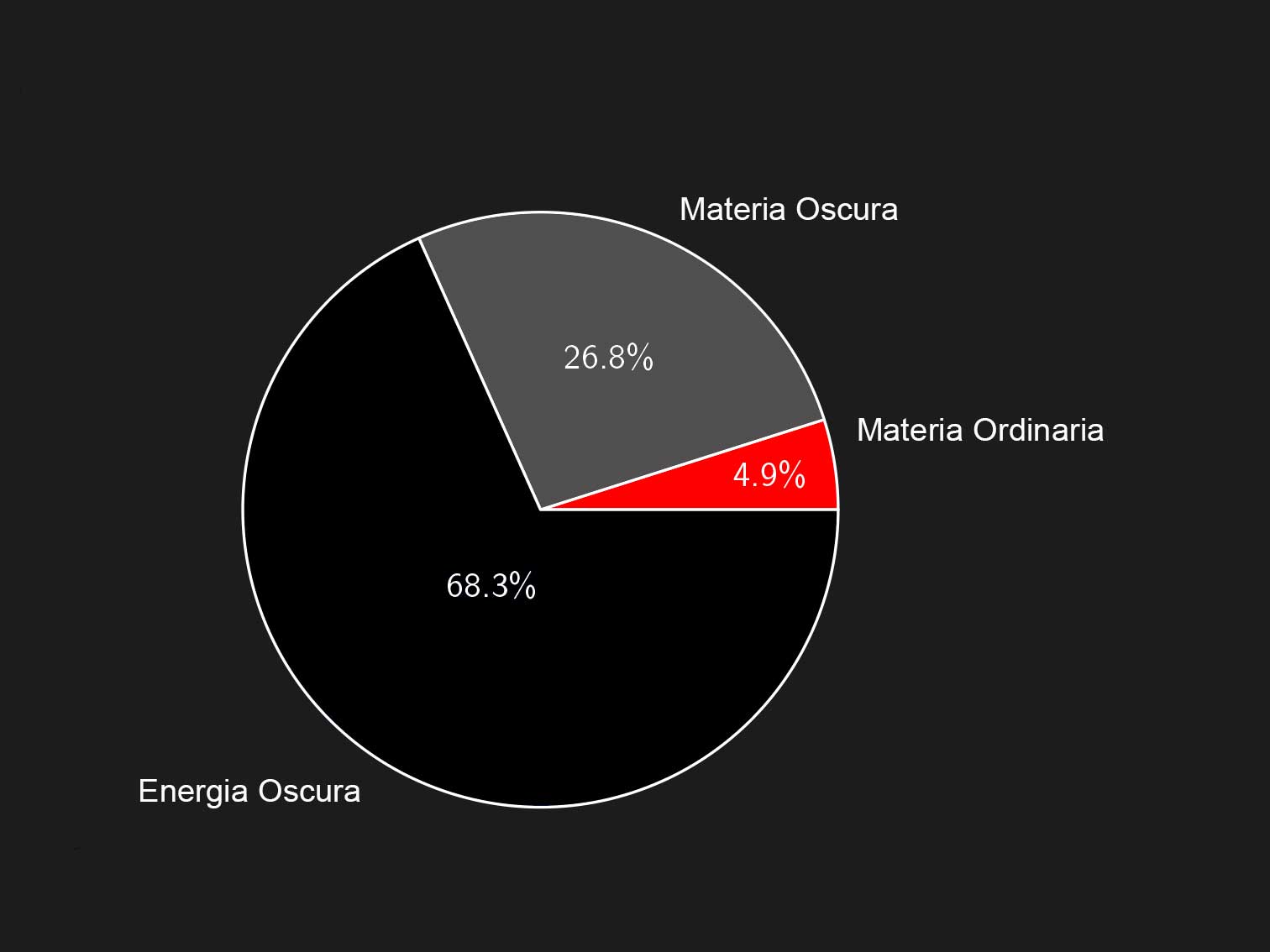

a energia è rappresentata da energia e materia oscure: la materia ordinaria, quella che costituisce il nostro mondo sensibile, non è che un misero 5%.

uazioni nella distribuzione di temperatura del CMB sarebbero state molto più grandi di quelle che osserviamo (ΔT/T ∼ 10-5). Il problema può essere superato con la presenza di materia oscura che non si accoppia direttamente ai fotoni. Lo studio dettagliato delle fluttuazioni nella temperatura del CMB consente, inoltre, di stabilire che il contributo della materia oscura all’attuale densità d’energia dell’Universo è circa il 25%; con l’aggiunta dei barioni, il contributo totale di materia all’attuale densità dell’Universo sale a circa il 30% della cosiddetta densità critica (∼ 5 atomi d’idrogeno a m3), ovvero la densità che rende piatta la geometria dell’Universo, come previsto dallo scenario inflazionario. Il resto è energia oscura.

L’aspetto forse più stupefacente dell’Universo, quindi, è che circa il 95% della su

Ora, se la materia oscura è fatta di particelle, è lecito nutrire l’ambizione di rivelarle, risultato a cui, pur

troppo, non siamo ancora giunti. Il problema è che catturare queste particelle è più difficile che rivelare i neutrini. Ciò è dovuto al fatto che mentre le caratteristiche fisiche di questi ultimi sono perfettamente determinate dalla teoria di Fermi, consentendo dunque di progettare rivelatori ad hoc per la loro osservazione, altrettanto non può dirsi della materia oscura. Sebbene alcune caratteristiche di queste ipotetiche particelle siano vincolate dalla necessità di rispettare i fatti osservativi precedentemente descritti, lo spettro di potenziali candidati, in termini di massa ed interazioni con la materia ordinaria, è estremamente vasto. Non esiste quindi un singolo esperimento che possa sottoporre a verifica tutte le possibili alternative.

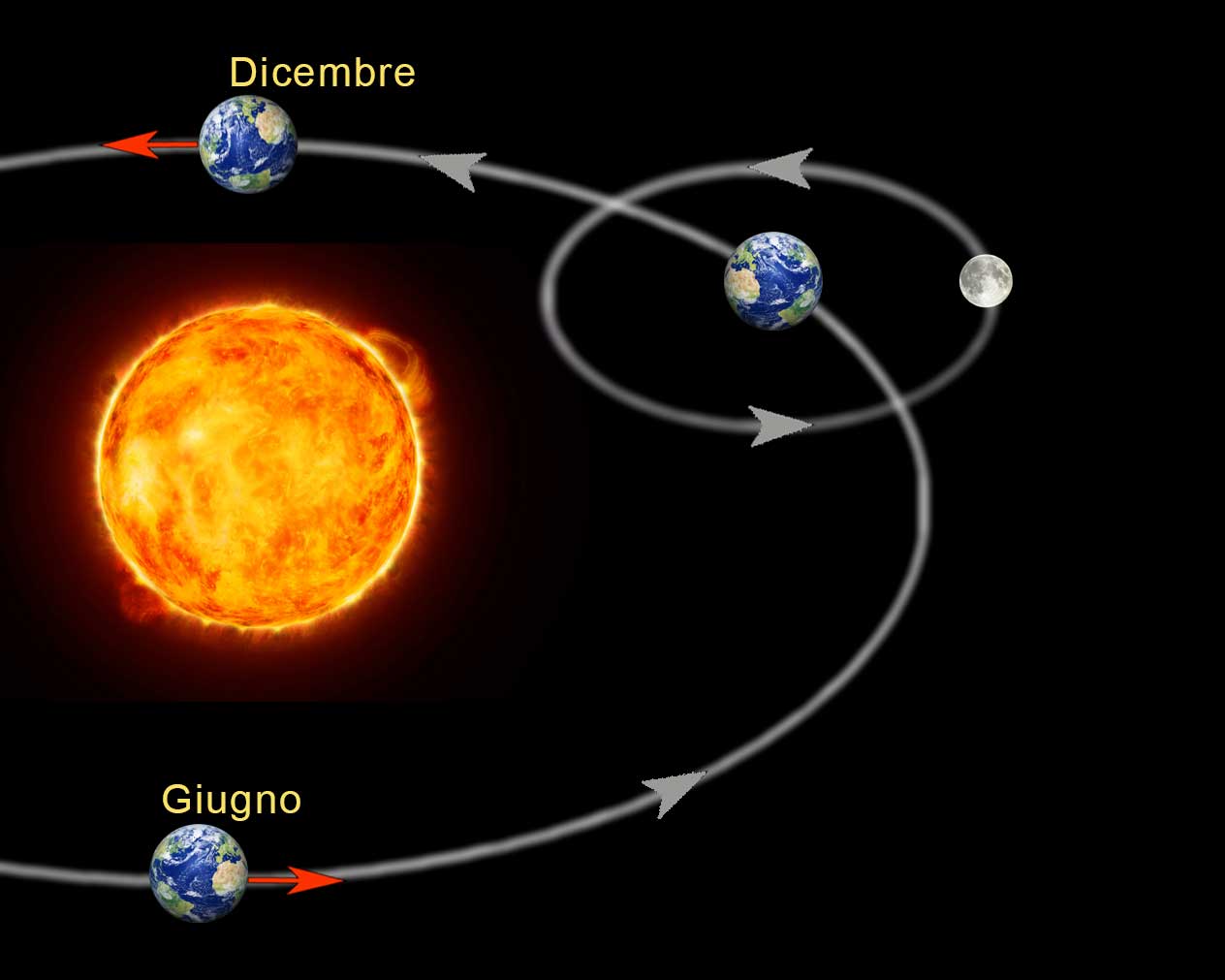

Per grandi linee, esistono tre fondamentali filoni di ricerca. L’osservazione diretta di materia oscura si basa sulla considerazione per cui il Sistema Solare, e con esso la Terra, ruotando intorno al centro della Galassia intercetta continuamente particelle dell’alone oscuro. Per catturare alcune di queste particelle vengono costruiti opportuni apparati, posti generalmente in laboratori sotterranei per minimizzare il rumore ambientale che renderebbe la rivelazione più difficile. Questo filone di ricerca ha nei Laboratori Nazionali del Gran Sasso dell’INFN uno dei principali centri di ricerca al mondo. È interessante notare che, a causa della rivoluzione della Terra intorno al Sole, il nostro pianeta si muove a volte coerentemente ed a volte in direzione opposta al moto del Sistema Solare intorno al centro galattico (Fig. 3).

Fig. 3 – Rappresentazione del moto della Terra all’origine del fenomeno della modulazione annuale nel flusso di particelle di materia oscura.

Fig. 3 – Rappresentazione del moto della Terra all’origine del fenomeno della modulazione annuale nel flusso di particelle di materia oscura.Questo dovrebbe indurre una modulazione annuale del flusso di materia oscura, con un picco intorno Maggio ed una riduzione massima intorno Novembre, un fenomeno che aiuterebbe a discriminare segnali genuini di materia oscura da altri potenziali segnali di fondo.

In effetti, l’esperimento DAMA/LIBRA al Gran Sasso osserva da più di un decennio un segnale con caratteristiche temporali compatibili con tale modulazione. Nonostante il grande interesse suscitato da questo esperimento, non possiamo ancora dirci certi di questa potenziale scoperta poiché altri esperimenti, con sensibilità sulla carta simili a quelle di DAMA/LIBRA, non osservano lo stesso segnale.

L’osservazione indiretta consiste nel ricercare segnali astrofisici riconducibili ad interazioni tra particelle di materia oscura tra di loro o con particelle di materia ordinaria. Sono ipotizzabili in effetti meccanismi che tramite queste interazioni producano, per esempio, fotoni di energia ben definita, che, se localizzati nello spazio, potrebbero indicare particolari addensamenti di materia oscura. Generalmente queste ricerche vengono effettuate da apparati lanciati su satelliti in orbita extra-atmosferica, che hanno maggiori capacità direzionali rispetto agli apparati terrestri.

Infine, si può sperare di produrre materia oscura in esperimenti agli acceleratori. In questo caso, generalmente, il segnale da ricercare è costituito da un evidente deficit nel bilancio energetico nello stato finale prodotto dalle collisioni, simile a quello dovuto alla presenza dei neutrini nei decadimenti beta. La sfida sperimentale consiste nel riuscire a discriminare un segnale genuino di materia oscura da tutti i deficit energetici dovuti, per esempio, a semplici (ed inevitabili) limitazioni nella risoluzione dell’apparato o alla produzione di neutrini.

È bene sottolineare ancora una volta che in tutti e tre i casi precedentemente analizzati il segnale da ricercare dipende fortemente dalle ipotesi a priori che si fanno sulle caratteristiche fisiche delle particelle ricercate, ipotesi che sono, in qualche modo, arbitrarie. In particolare non esiste nessuna ragione incontrovertibile per escludere che tali particelle abbiano soltanto interazioni di tipo gravitazionale con la materia ordinaria, cosa che le renderebbe, a tutti gli effetti pratici, impossibili da rivelare.

La caccia a queste particelle è aperta da tempo e continua, con mezzi sempre più potenti.

Il paradigma MOND

L’ipotesi che la materia oscura sia composta da particelle (non-relativistiche) che interagiscono solo gravitazionalmente – materia oscura fredda (CDM dall’acronimo inglese) – è convincente dalla scala cosmologica fino a quella delle galassie. È qui dove il paradigma entra in difficoltà.

Negli anni sono state elaborate simulazioni abbastanza accurate del comportamento di sistemi costituiti da miliardi di particelle che interagiscono solo gravitazionalmente in un Universo in espansione. Queste simulazioni hanno fornito una descrizione dettagliata della struttura degli aloni su tutte le scale, dagli oggetti sub-galattici ai grandi ammassi di galassie. Al disotto di una certa distanza dal centro, la densità diviene molto grande, ovvero c’è una cuspide; al disopra, invece, la densità decresce abbastanza velocemente con la distanza dal centro, il che, per grandi distanze, si traduce in una velocità di rotazione lentamente decrescente.

Una velocità decrescente è in disaccordo con l’andamento asintotico piatto delle curve di rotazione, e rappresenta un’apparente falsificazione dell’ipotesi della CDM. Inoltre, la predetta cuspide interna spesso non si accorda con le osservate curve di rotazione: queste sono generalmente più consistenti con un alone avente un nocciolo di densità costante. Le simulazioni, infine, predicono la presenza di molti sub-aloni, i cosiddetti aloni satelliti, molti più di quelli effettivamente osservati nell’intorno delle galassie a spirale quale la Via Lattea.

La velocità asintotica costante fin da subito apparve molto strana agli occhi del fisico israeliano Mordechai Milgrom, il quale, nel 1980, riflettendo su questo aspetto affrontò il problema da un punto di vista completamente diverso. La necessità di aggiungere materia oscura è soltanto un’inferenza della teoria gravitazionale Newtoniana e, quindi, se non riusciamo a predire curve costanti, invece di creare una nuova classe di materia, dovremmo sistemare Newton. La modifica proposta da Milgrom è semplice: quando l’accelerazione a cui è soggetto un corpo diventa minore di una certa accelerazione critica a0, dell’ordine di 10-10 m/s2 (un centimiliardesimo dell’accelerazione g sulla superficie della Terra), la forza non è più proporzionale all’accelerazione (F = m a), come prescritto dalla seconda legge di Newton, bensì al suo quadrato (F = m a2/a0). Da qui il nome MOND (dall’inglese “MOdified Newtonian Dynamics”) attribuito alla corrispondente teoria.

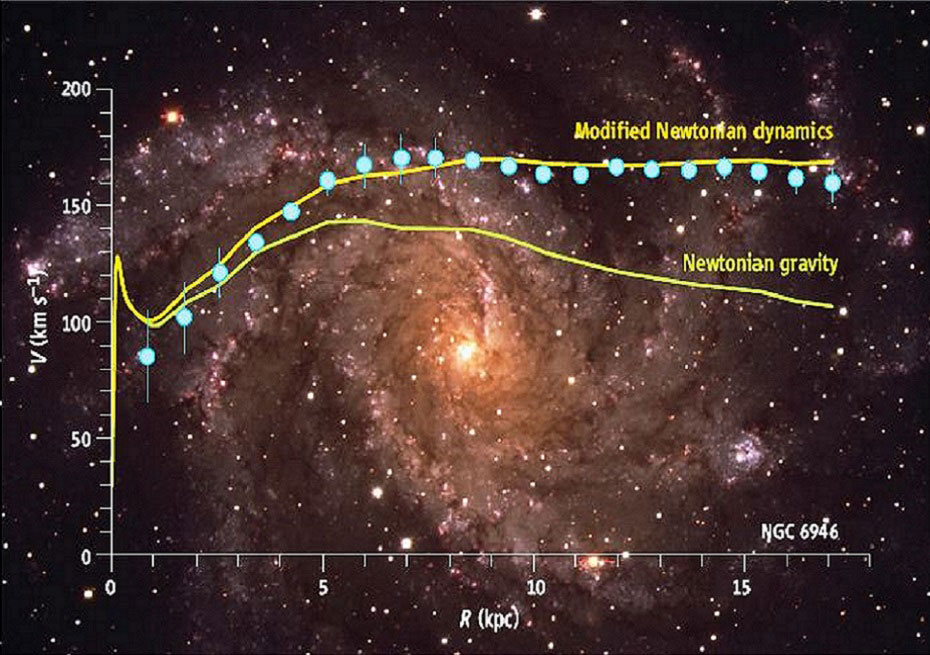

Il risultato di questa modifica è chiaramente evidente nella Fig. 4.

Fig. 4 – Curva di rotazione della galassia NGC 6946: confronto delle predizioni della dinamica Newtoniana e di MOND con le osservazioni.

Fig. 4 – Curva di rotazione della galassia NGC 6946: confronto delle predizioni della dinamica Newtoniana e di MOND con le osservazioni.L’accordo con i dati sperimentali non deve entusiasmare più di tanto: la teoria è stata costruita per riprodurre le curve di rotazione piatte. Ciò che stupisce, semmai, è che lo stesso valore di accelerazione critica vada bene per un gran numero di galassie.

C’è, però, un importante aspetto da sottolineare. Le osservazioni mostrano che il valore costante della velocità di rotazione periferica dipende dalla massa osservabile (la cosiddetta massa barionica) della galassia (legge Tully-Fisher). Questa correlazione è valida per vari tipi di galassie e di masse barioniche: dalle galassie nane di piccola massa, dominate dai gas, fino alle massicce grandi spirali con sostanziali rigonfiamenti centrali. Nel contesto dell’ipotesi della materia oscura, questo aspetto implicherebbe una correlazione esatta tra la massa barionica del relativamente piccolo oggetto nel centro e la velocità di rotazione di particelle in orbite circolari nell’esteso alone oscuro periferico, correlazione che appare assolutamente innaturale. Nel contesto di MOND, questa correlazione è assolutamente naturale e regolata da un coefficiente pari all’inverso del prodotto tra la costante gravitazionale G di Newton e l’accelerazione critica a0. In linea di principio, questa accelerazione è un parametro diverso da quello che determina la forma delle curve di rotazione. Sorprendentemente, le osservazioni, però, conducono allo stesso valore per entrambi. Sebbene questa fenomenologia fosse nota prima della formulazione di MOND, nulla garantiva che il valore di a0 necessario per riprodurre la legge di Tully-Fisher avesse a che fare con la forma delle curve di rotazione nella regione piatta. Quindi, nel contesto di MOND, una singola formula unifica due aspetti centrali della fenomenologia delle galassie a spirale.

A questo punto è necessario chiedersi: da dove salta fuori questa accelerazione critica? Possiamo individuare un valore naturale per essa? L’aspetto sorprendente è che il valore di a0 desunto dallo studio delle curve di rotazione galattica è dello stesso ordine di grandezza del prodotto tra la velocità della luce e il valore attuale della costante di Hubble. Questo porta ad ipotizzare che MOND potrebbe essere un effetto dell’espansione cosmologica sulla dinamica dei sistemi locali.

Abbiamo scoperto anche una possibile origine per l’accelerazione critica, per cui tutto bene con MOND? Non è così: la teoria presenta, dal punto di vista empirico, degli aspetti problematici, primo tra tutti il fatto che essa non è in grado di descrivere completamente la discrepanza di massa negli ammassi di galassie. Di una cosa, però, siamo certi: è possibile riprodurre questa fenomenologia corrompendo, per così dire, la purezza di MOND con l’aggiunta di particolare “materia oscura”, quale, ad esempio, neutrini ordinari con massa tra 2 e 4 eV (che i neutrini posseggano una massa diversa da zero lo abbiamo appreso all’inizio degli anni ’90 del secolo scorso, quando, per la prima volta, fu osservato il fenomeno dell’oscillazione, ovvero il cambiamento della loro natura durante la propagazione; il problema è che da queste misure riusciamo a determinare solo il quadrato della differenza di massa tra i vari tipi di neutrini), oppure neutrini “sterili” (non completamente interagenti) con massa dell’ordine di 10 eV.

Esistono anche problemi di carattere teorico. Il più pressante è che MOND, a più di trenta anni dalla sua formulazione, è tuttora priva di una versione relativistica accettata. Senza questa estensione non è possibile affrontare la cosmologia e il problema della formazione delle strutture, ovvero gli aspetti su larga scala, dove il paradigma standard, invece, funziona molto bene. Insomma, lo studio del CMB esula dal campo di applicazione di MOND.

Nell’ultima decade, sono state proposte parecchie versioni relativistiche di MOND, tutte potenzialmente in grado di risolvere i problemi cosmologici. Molte di queste teorie, tra queste quella proposta dal fisico israeliano Jakob Bekenstein, richiedono l’introduzione di campi addizionali, di natura diversa da quello gravitazionale. Queste teorie sono più complicate, e meno estetiche, della Relatività Generale e non è ancora del tutto chiaro come esse affrontino gli aspetti cosmologici quali l’entità e la distribuzione delle anisotropie del CMB. L’interesse per questo tipo di teorie risiede nel fatto che tutte richiedono una modifica della teoria di Einstein, cosa che, prima o poi, dovrà avvenire. Sappiamo, infatti, che la Relatività Generale non può essere la risposta definitiva al problema della gravità. Al suo interno, infatti, contiene l’incubo più spaventoso per i fisici: l’infinito! Al centro di un buco nero; nel Big Bang all’inizio dell’Universo. La maggior parte dei fisici ritiene che non ci sia motivo di preoccuparsi. Questi infiniti spuntano fuori quando si applica la teoria su distanza piccolissime, dove, necessariamente, occorre tener conto anche della Meccanica Quantistica. Per tale ragione, molti ripongono le loro speranze nella cancellazione di queste divergenze da parte dell’ancora sfuggente unificazione della Relatività Generale con la Meccanica Quantistica, ovvero nella Gravità Quantistica: la teoria finale dove i due pilastri della fisica del ‘900, ciascuno rinunciando a qualcuna delle proprie caratteristiche, alla fine, confluiranno.

Ma non è solo il problema delle singolarità a dirci che la Relatività Generale non può essere la teoria definitiva dell’interazione gravitazionale. È lo stesso modello cosmologico che attualmente riscuote maggior credito presso i fisici – ΛCDM: la costante cosmologica (Λ) più la materia oscura fredda (CDM) – a richiedere di andare oltre la Relatività Generale. Come abbiamo visto, esso richiede due sorgenti addizionali, la materia e l’energia oscure, per le quali non c’è evidenza indipendente dalle osservazioni astronomiche, con densità d’energia fissate da queste osservazioni e che, nell’epoca presente, risultano, misteriosamente, pressoché coincidenti.

In conclusione, rimaniamo con alcune domande. Qual è la soluzione all’enigma delle “anomalie gravitazionali” di cui abbiamo parlato? Materia oscura su scala cosmica e dinamica modificata su quella galattica? C’è un campo che si comporta come materia oscura su larga scala, ma mima una dinamica modificata su scale più piccole? Può la fenomenologia di materia oscura, energia oscura e MOND essere unificata in una singola teoria? Ci sono due possibilità diametralmente opposte: esistono particelle di materia oscura ma non possono manifestare la loro presenza sulla scala delle galassie; non c’è materia oscura e la discrepanza cosmica di massa è un aspetto di MOND (della sua estensione relativistica) su larga scala.

Oppure, la soluzione è in qualcosa di completamente inimmaginato che si pone a un livello più profondo e che al progredire della scala sfuma da MOND a particelle di materia oscura.

Gli esperimenti in fase di realizzazione per la rivelazione delle particelle di materia oscura e le future campagne di osservazione astrofisiche/cosmologiche, ci illumineranno su questo affascinante problema (D. Babusci, F. Bossi).

Questa (lunghissima) Fisica News è tratta dall’intervento degli autori durante la conferenza Il lato oscuro dell’Universo: teorie e visioni tenutasi ai LNF il 4 dicembre 2017.

Fin qui l'approccio classico.

In sintesi, esso si basa o sulle ipotesi di particelle esotiche non interagenti con la radiazione elettromagnetica( non le vedo!) ma interagenti dal punto di vista gravitazionale, oppure modificando direttamente le leggi sulla gravità (teorie MOND).

la mia ipotesi

Ma c'è un'altra possibilità, legata alla struttura quantistica della gravità alla scala di Planck. Come ho detto nel precedente articolo, la truttura a schiuma di spin (il fatto cioè che la struttura dello spazio tempo è granulare e caotica) determina strutture di vario tipo: aperte, chiuse e stabili, chiude ed instabili.Schiuma di spin

La dinamica su larga scala della spin foam determina la forma dell'universo, tra cui la sua espansione accellerata( cioè l'energia oscura) mentre gli inviluppi locali determinano l'insorgenza dell masse,più o meno stabili nel caso di inviluppi chiusi, nel senso che se sono inviluppi di lunga o lunghissima durata la materia si può ritenere stabile.

Ma cosa accade nel caso di inviluppi chiusi instabili?

La materia non ha il tempo di palesarsi come tale, ma comunque concorre all'insorgenza di forse gravitazionali statisticamente percepibili. Ecco l'avvento della materia oscura, come puro fenomeno quantistico fatto di infinitesimi contributi ma che si sommano dulla media scala.

In altre parole, la granularità dello spazio-tempo, assieme con la sua intrinseca instabilità data dalle leggi della meccanica quantistica, sono sufficienti a spiegare gran parte dei misteri insoluti che abbiamo circa la struttura sia a piccola che a grande scala del nostro universo.

Noi non siamo altro che ologrammi di uno spazio-tempo granulare

Premessa doverosa: queste considerazioni sono derivate essenzialmente da tre assunzioni.La natura procede a salti ed è fatta di salti. La continuità è solo un comodo espediente per semplificare la spiegazione di ciò che accade. Quando disegniamo qualcosa oppure quando vediamo la tv, se ci avviciniamo possiamo scorgere che quello che abbiamo visto o disegnato è in realtà una sequenza di punti. Tutto è quantizzato, fatto di parti discrete e non ulteriormente divisibili. E queste parti non possono stare ferme o meglio se ne fermo alcune, altre loro caratteristiche scappano via.

Ci sono quindi dei limiti invalicabili alla conoscenza completa del mondo, non posso conoscere tutto. Inoltre la conoscenza che posso avere dipende fondamentalmente dall'interazione che ho, dalla relazione che ho, con le cose. Senza relazione non posso dire che esistano le cose, nessuno mi autorizza a farlo.

Ulteriore considerazione. Quando descrivo dei fenomeni, di qualunque natura essi siano, noto che sono inseriti in un contesto. Tutta la storia umana, non solo della scienza (pensiamo alla politica!), ha sempre inserito, anche implicitamente, ciò che accade in un sottofondo, come un palcoscenico in cui recitano degli attori. Anche le più recenti conquiste o teorie scientifiche, come la meccanica quantistica o la teoria delle stringhe, tengono conto di un sottofondo, background, dato per scontato ed "esterno" alle teorie. In altre parole, descrivo un fatto supponendo che il contesto sia dato e sostanzialmente immutabile.

La teoria generale della reltività di Einstein, invece, è il tentativo, riuscito , ma cercherò di spegare dopo, quasi riuscito, di strutturare un qualcosa di indipendente dal sottofondo, in cui cioè anche il sottofondo fa parte della rappresentazione, del luogo specifico in cui accadono i fenomeni. Parte integrante ed interagente, non passiva, inerte. E la nuova fisica deve muoversi così: indipendenza dal background (si chiama covarianza) e pure indipendente dal particolare sistema di coordinate che uso (diffeomorfismo). La nuova teoria deve gestire solo le relazioni tra gli elementi interagenti, che generano sia l'evoluzione dei fenomeni che il luogo in cui si svolgono. Le relazioni generano l'esistenza stessa delle cose.

Come accennavo, la teoria della relatività generale spiega molto bene i fenomeni gravitazionali su media e larga scala. E lo fa ipotizzando che la forza di gravità è un effetto della curvatura geometrica dello spazio-tempo. Le masse curvano tale spazio-tempo e la curvatura determina le traiettorie delle masse stesse, in un continuo ed incessante balletto. Tale teoria però presuppone che lo spazio-tempo sia continuo e tale caratteristica porta alla perdita di significato della teoria stessa quando tratta di masse molto grandi concentrate in uno spazio molto piccolo (buchi neri). Le grandezze in gioco, come le masse ed i volumi, divergono: o infinite o infinitamente piccole. Affiorano inoltre dei paradossi, come la perdita totale delle informazioni che cadono dentro un buco nero, cosa reputata impossibile. Tentare di risolvere tali limiti è lo sforzo di tutto un settore della fisica che si occupa di fondere la relatività generale con l'altra teoria della natura, la meccanica quantistica, che ha un approccio con gli infiniti meno traumatico. E come si cerca di farlo?

Anche lo spazio ed il tempo sono quantizzati, granulari. Lo spazio cioè è suddivisibile fino ad un certo punto, che si chiama lunghezza di Plank, pari a qualcosa come 1,6 10-35 metri. E' un valore molto piccolo. Se un protone fosse grande come il sole, tale distanza sarebbe meno di un millimetro, ma è pur sempre diversa da 0. La meccanica quantistica impone tale limite: se ci fosse un valore minore tutto l'universo, tutte le particelle in esso contenute, collasserebbero in un buco nero.

La lunghezza di Plank determina la superfice ed il volume di Plank basta farne il quadrato o il cubo). Lo spazio-tempo è cioè una sorta di reticolo, di "cubetti" piccolissimi che riempiono tutto l'universo ed in cui sono collocate e si muovono tutte le masse. Tale reticolo, a sua volta, sempre per le leggi della meccanica quantistica (principio di indeterminazione di Heisemberg), non può stare fermo ma si agita, si deforma, è più simile alla schiuma da barba che ad una rete. Al vertici di tale reticolo sono collocati gli atomi di spazio. I fisici lo chiamano "schiuma di spin". Nella figura in alto è rappresentata una simulazione di tale "spin foam". La parola spin sottintende che sono strutture orientate e quindi capaci potenzialmente di possedere una qualche informazione, cosa che ci potrà tornare utile in seguito.

Questa impossibilità di star fermi e quindi di stare sempre in interaziore reciproca, deformandosi, allargandosi, stirandosi dipende dal fatto che anche gli atomi di spazio obbediscono, appunto, al principio di indeterminazione di Heisemberg, uno dei pilastri della meccanica quantistica. Tale principio stabilisce, oltre alla impossibilità di avere misure precise contamporanee della posizione e della velocità delle particelle, anche l'impossibilità di misurarne la loro energia con precisione. Sono fatti acclarati, strani e non intuitivi, ma senza di esso non funzionerebbero i cellulari. Questa indeterminazione dell'energia, in questo caso degli atomi di spazio, come vedremo, ha ripercussioni fondamentali nell'evoluzione di tutto l'universo. Facciamo prima una premessa terminologica; la differenza tra vuoto e niente. Il vuoto è lo spazio senza materia. Il niente è ciò che sta tra gli atomi di spazio. Le interazioni fondamentali della natura, forte, debole ed elettromagnetica si hanno anche nel vuoto, mentre gli atomi di spazio non hanno bisogno di nulla per interagire. Lo spazio è granulare. Strano, no?

Detto questo, l'indeterminazione sull'energia dei quanti di spazio può determinare che lo spazio possa acquistare un'energia diversa da 0 ed anche esercitare una pressione. Da qui può derivare una caratteristica misurata dello spazio vuoto: la costante cosmologica, una pressione espansiva molto bassa ma capace di spingere l'universo ad espandersi in modo accellerato. La storia della costante cosmologica è una corsa ad ostacoli, via via superati. La quantizzazione dello spazio cioè può essere la spiegazione della sua pressione intrinseca, non gli effetti quantomeccanici della materia, che porterebbero a previsioni assurde sul valore della costante cosmologica Λ. Se volete approfondire cosa sia il vuoto fisico e che proprietà possiede potete dare uno sguardo a questo video cosa è il vuoto quantistico . Attenzione, però! Anche se appare tutto strano ed esoterico, dobbiamo tener presente che le caratteristiche del vuoto attuali sono comunque un fatto standard e consolidato. Qui si cerca di fare uno step in più, piuttosto temerario. vediamo come.

A questo punto possiamo

fare un'ipotesi sulla gravità. Quante volte abbiamo visto un'immagine del genere? Masse che distorcono la struttura geometrica dello spazio-tempo come palle su una rete elastica? ma cosa è questa rete? Possiamo dare una possibile risposta: è il reticolo degli atomi di spazio che viene distrurbato dalla presenza della materia. Lo spazio si deforma e quindi le traiettorie di tutti gli oggetti si deformano, compreso la luce che lo attraversa. Le traiettorie naturali degli oggetti seguono le deformazioni del reticolo e si incurvano; ecco l'affioramento della gravità.

Bordi.

Fino a questo punto abbiamo trattato lo spazio e la materia in esso contenuta in modo diverso: sono pur sempre entità distinte anche se la teoria quantistica della gravità è indipendente dal background. Essa va intesa sempre nel senso che "la materia incurva lo spazio-tempo e la curavatura dice alla materia come muoversi". Ma qui entrano in gioco Archibald Wheeler, Steven Hawking e Bekenstein.  I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo ( https://www.giamod.it/nuova/index.php/84-fisica-e-dintorni/163-bit-dell-universo ) che dà il via al concetto di universo olografico, tramite il quale possiamo concepire il nostro modo descritto completamente dai bits (qbits) immagazzinati nel bordo che lo circonda. Ma osserviamo che non è necessario pensare ad un bordo universale tassellato di celle della dimensione di aree di Plank: ogni bordo che circonda qualunque cosa presente nel nostro universo contiene le informazioni necessarie e sufficienti per descrivere cosa c'è dentro di esso. Ed allora: se la schiuma di spin nel suo eterno cambiare forma per gli effetti quantistici che la governano di "corrugasse" in una forma chiusa, in un bordo, appunto, cosa accadrebbe?

I loro lavori sulla entropia dei buchi neri (il fatto che tale entropia sia proporzionale alla superficie dell'orizzonte degli eventi) possono gettare una luce nuova, direi rivoluzionaria, su come può essere fatto ciò che esiste ad una scala più profonda. L'entropia dell'universo si può pensare "mappata" sul suo bordo ( si veda pure un mio precedente articolo ( https://www.giamod.it/nuova/index.php/84-fisica-e-dintorni/163-bit-dell-universo ) che dà il via al concetto di universo olografico, tramite il quale possiamo concepire il nostro modo descritto completamente dai bits (qbits) immagazzinati nel bordo che lo circonda. Ma osserviamo che non è necessario pensare ad un bordo universale tassellato di celle della dimensione di aree di Plank: ogni bordo che circonda qualunque cosa presente nel nostro universo contiene le informazioni necessarie e sufficienti per descrivere cosa c'è dentro di esso. Ed allora: se la schiuma di spin nel suo eterno cambiare forma per gli effetti quantistici che la governano di "corrugasse" in una forma chiusa, in un bordo, appunto, cosa accadrebbe?

Si creerebbe una massa! Le masse non sono altro che bordi di una struttura granulare chiusa dello spazio tempo. La massa non è più qualcosa di esterno allo spazio, ma è lo spazio stesso non piatto ma chiuso in bolle . Tali bolle possono avere energia e/o struttura sufficiente per essere stabili ed allora generano materia sufficientemente stabile (protoni, elettroni, neutroni , quarks) oppure rompersi generando materia instabile. Un bordo può racchiudere uno o altri bordi, creando strutture via via più grandi. L'informazione diviene sempre più ricca e complessa arrivando a rappresentare qualunque cosa presente nell'universo, come una immensa matrioska fatta di pura informazione, capace anche di fare questo: osservare se stessa e studiarla (cioè, noi).

In più, se osserviamo la figura a lato, ed applicando una delle proprietà degli ologrammi, il fatto cioè che qualunque sua porzione contenga le informazioni di tutto l'ologramma, possiamo in qualche modo dedurre che cose anche molto lontane nel mondo tridimensionale siano in realtà vicinissime sul bordo, separate cioè da pochissimi atomi di spazio. Sulla superficie cioè scompare la distanza macroscopica. Ecco spiegata la non località della meccanica quantistica: oggetti apparentemente lontanissimi in realtà possono esere vicinissimi. ecco spiegato l'entanglement.

Cioè, in altre parole, tutto l'universo non è altro che l'emergere di pura e semplice informazione.

Come è strano il mondo. Non ha niente a che vedere con ciò che appare. Omaggio a Rovelli.

...

Parlo di fisica, musica, viaggi di vario tipo.

Un posto dove sbariare, insomma.

Abbiamo 152 visitatori e nessun utente online